Die Erfindung des Computers ist keine Geschichte eines einzelnen Moments, sondern eine faszinierende Reise durch Jahrhunderte technologischer Entwicklung. Die Computergeschichte beginnt nicht mit modernen Geräten, sondern mit den grundlegenden menschlichen Bedürfnissen, komplexe Berechnungen zu vereinfachen und zu beschleunigen.

Unsere Entdeckungsreise durch die Erfindung des Computers zeigt, dass technologische Durchbrüche das Ergebnis kollektiver Anstrengungen vieler brillanter Köpfe sind. Von mechanischen Rechenmaschinen bis zu elektronischen Systemen haben Wissenschaftler und Ingenieure Schritt für Schritt die Grundlagen geschaffen, die wir heute als Computer kennen.

Dieser Artikel erkundet die spannenden Ursprünge und Entwicklungen, die uns von einfachen Rechenhilfen zu leistungsstarken Computern geführt haben. Wir werden die wichtigsten Meilensteine und Pioniere beleuchten, die die Computergeschichte geprägt haben.

Die Geschichte des Computers – Von der Antike bis heute

Die Entwicklung von Rechenmaschinen ist eine faszinierende Reise durch die Menschheitsgeschichte. Frühe Computer und Rechenwerkzeuge zeigen die unglaubliche Kreativität und technische Intelligenz unserer Vorfahren. Technologische Innovationen begannen bereits in der Antike und legten den Grundstein für unsere moderne digitale Welt.

Erste Rechenmaschinen der Geschichte

Menschen entwickelten schon sehr früh Methoden, um komplexe mathematische Berechnungen durchzuführen. Die ersten Rechenmaschinen waren einfache, aber clevere Werkzeuge, die mathematische Operationen erheblich vereinfachten.

- Einfache Zählmethoden mit Steinen

- Primitive Rechenbretter

- Mechanische Zählgeräte

Der Abakus als Ursprung

Der Abakus gilt als eine der ältesten Rechenmaschinen der Welt. Dieses erstaunliche Instrument wurde bis ins 17. Jahrhundert in verschiedenen Kulturen verwendet und ermöglichte präzise mathematische Berechnungen.

| Zeitraum | Kultureller Ursprung | Bedeutung |

|---|---|---|

| 2400 v. Chr. | Mesopotamien | Erste Nachweise des Abakus |

| 17. Jahrhundert | Globale Nutzung | Weiterhin bedeutendes Rechenwerkzeug |

Mechanismus von Antikythera

Der Mechanismus von Antikythera, eine komplexe analoge Rechenmaschine aus dem 1. Jahrhundert v. Chr., war seiner Zeit weit voraus. Diese faszinierende Erfindung demonstrierte bereits fortschrittliche technische Fähigkeiten und mathematisches Verständnis.

„Der Mechanismus von Antikythera war ein astronomisches Wunderwerk, das die technologische Brillanz der Antike offenbart.“

Frühe mechanische Rechenmaschinen im 17. Jahrhundert

Das 17. Jahrhundert war eine entscheidende Epoche für die Entwicklung von mechanischen Rechenmaschinen. Wissenschaftler und Erfinder begannen, komplexe mechanische Systeme zu entwickeln, die mathematische Berechnungen automatisieren konnten.

- Wilhelm Schickard: Entwickelte 1623 die erste Vier-Spezies-Maschine

- Blaise Pascal: Konstruierte 1642 die berühmte Pascaline

„Die mechanischen Rechenmaschinen waren die Vorläufer unserer modernen Computer und revolutionierten das mathematische Denken ihrer Zeit.“

Schickards Rechenmaschine war ein bemerkenswertes Gerät. Sie konnte alle vier Grundrechenarten (Addition, Subtraktion, Multiplikation und Division) ausführen. Diese Fähigkeit war für das 17. Jahrhundert eine außergewöhnliche technologische Leistung.

| Erfinder | Jahr | Mechanische Rechenmaschine | Besonderheiten |

|---|---|---|---|

| Wilhelm Schickard | 1623 | Rechenuhr | Erste Vier-Spezies-Maschine |

| Blaise Pascal | 1642 | Pascaline | Revolutionäre Rechenmaschine |

Pascals Pascaline war nicht minder beeindruckend. Sie ermöglichte präzise Berechnungen und war ein wichtiger Schritt in der Entwicklung mechanischer Rechenmaschinen. Diese Innovationen legten den Grundstein für die spätere Computertechnologie.

Die Entwicklung der ersten programmierbaren Rechner

Die Geschichte der Pioniere der Informatik zeigt, wie bahnbrechende Erfindungen die Grundlage für moderne Computertechnologie schufen. In der ersten Hälfte des 19. Jahrhunderts begannen Wissenschaftler, die Möglichkeiten programmierbarer Rechner zu erkunden und zu entwickeln.

Charles Babbage und die Vision einer analytischen Maschine

Charles Babbage gilt als einer der wichtigsten Pioniere der Informatik. Seine Analytical Engine war ein revolutionärer Entwurf, der weit seiner Zeit voraus war. Zwischen 1820 und 1822 entwickelte er die Differenzmaschine, einen mechanischen Rechner, der komplexe mathematische Berechnungen durchführen konnte.

- Erste Konzepte für programmierbare Rechner

- Mechanische Rechenmaschine mit Lochkarten

- Grundlage für moderne Computerarchitektur

Ada Lovelace – Die Wegbereiterin der Programmierung

Ada Lovelace, eine brillante Mathematikerin, erkannte als erste die umfassenden Möglichkeiten programmierbarer Rechner. Im Jahr 1843 schrieb sie das weltweit erste Computerprogramm und legte damit den Grundstein für die moderne Softwareentwicklung.

Herman Hollerith und die Revolution der Datenverarbeitung

Herman Hollerith entwickelte ein wegweisendes Lochkartensystem, das die Datenverarbeitung grundlegend veränderte. Seine Erfindung ermöglichte eine schnellere und effizientere Informationsverarbeitung und bildete eine wichtige Brücke zu elektronischen Computern.

Die Pioniere der Informatik schufen die Grundlage für unsere moderne digitale Welt.

Wer hat den Computer erfunden?

Die Erfindung des Computers ist keine Geschichte eines einzelnen Genies, sondern ein komplexer Prozess der technologischen Evolution. Verschiedene Wissenschaftler und Ingenieure trugen über Jahrzehnte zur Entwicklung des Computers bei.

Der Weg zur Erfindung des Computers lässt sich in mehrere wichtige Phasen unterteilen:

- Mechanische Rechenmaschinen der Antike

- Erste programmierbare Rechner im 19. Jahrhundert

- Elektronische Rechner des 20. Jahrhunderts

„Computer wurden nicht erfunden, sondern entwickelt“ – Computerhistoriker

Schlüsselfiguren wie Charles Babbage, Ada Lovelace, Alan Turing und Konrad Zuse leisteten entscheidende Beiträge zur Erfindung des Computers. Ihre Innovationen bildeten die Grundlage für moderne Computersysteme.

Keine einzelne Person kann als alleiniger Erfinder des Computers gelten. Stattdessen war es ein globales Gemeinschaftsprojekt, bei dem Wissenschaftler aus verschiedenen Ländern und Disziplinen zusammenarbeiteten.

Konrad Zuse und die Z-Serie

Die Geschichte der Computertechnologie ist eng mit dem Namen Konrad Zuse verbunden. Als deutscher Pionier der Informatik entwickelte er revolutionäre Rechensysteme, die die Grundlage für moderne Computer schufen.

Konrad Zuse war ein visionärer Ingenieur, der die Computerwelt grundlegend veränderte. Seine Arbeit an der Z-Serie markierte einen entscheidenden Wendepunkt in der Entwicklung programmierbarer Rechenmaschinen.

Die Z1 – Ein Meilenstein der Programmierbarkeit

Die Z1 gilt als der erste programmierbare Rechner der Welt. Zuse entwickelte diese Maschine in seiner Berliner Wohnung zwischen 1936 und 1938. Wichtige Merkmale der Z1 waren:

- Vollständig mechanische Konstruktion

- Binäres Rechensystem

- Erste Implementierung von Speicherprogrammierung

Z3 – Der Durchbruch des elektronischen Computers

Der Z3 Computer stellte 1941 einen absoluten Durchbruch in der Computertechnologie dar. Als erster vollelektronischer, frei programmierbarer Rechner der Welt setzte Zuse neue Maßstäbe in der Rechentechnik.

Der Z3 war seiner Zeit weit voraus und legte den Grundstein für moderne Computerarchitektur.

Zuses Innovationen beim Z3 Computer umfassten:

- Erste Verwendung von Gleitkommazahlen

- Binäres Rechensystem

- Programmierbarer elektronischer Rechner

Die Arbeit von Konrad Zuse revolutionierte die Computertechnologie und inspirierte nachfolgende Generationen von Informatikern weltweit.

John von Neumann und die moderne Computerarchitektur

John von Neumann war ein Schlüsselpionier in der Computerentwicklung. Im Jahr 1945 entwickelte er ein revolutionäres Konzept, das die Grundlage für moderne Computerarchitektur bilden sollte. Seine bahnbrechende Idee des gespeicherten Programms veränderte die Art und Weise, wie Computer konstruiert und programmiert werden.

Die von-Neumann-Architektur basiert auf einigen zentralen Prinzipien:

- Vereinigung von Programm- und Datenspeicher

- Sequenzielle Ausführung von Befehlen

- Zentrale Recheneinheit zur Verarbeitung von Informationen

Während seiner Arbeit am Princeton Institute for Advanced Study entwickelte von Neumann ein Modell, das die Computerentwicklung fundamental prägte. Seine Konzepte ermöglichten es, komplexe Berechnungen effizienter und schneller durchzuführen.

„Die Zukunft der Computertechnologie liegt in der Fähigkeit, Informationen schnell und präzise zu verarbeiten.“

Die Bedeutung von Neumanns Arbeit kann nicht überschätzt werden. Fast alle modernen Computer basieren noch heute auf seinen grundlegenden Architekturprinzipien, was seine bleibende Bedeutung für die Computerentwicklung unterstreicht.

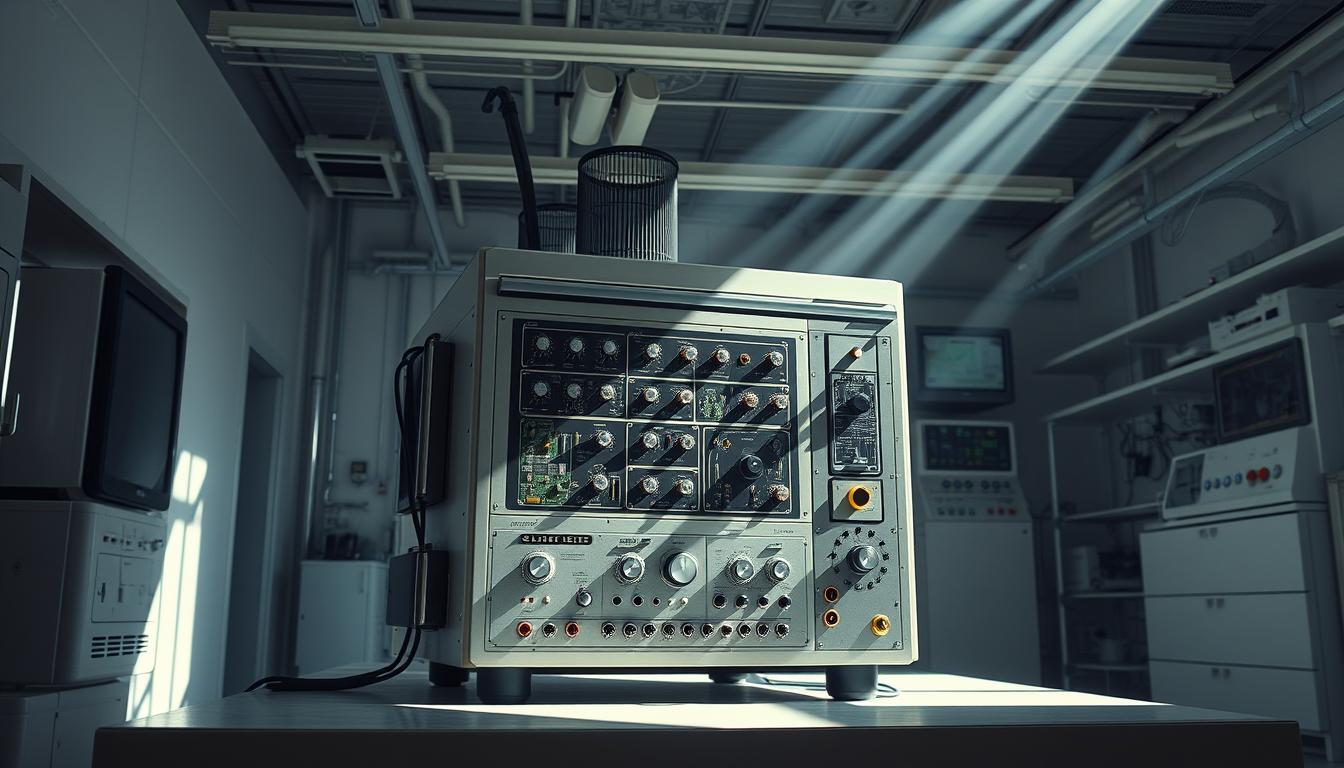

Die Entwicklung des ENIAC

Der ENIAC (Electronic Numerical Integrator and Computer) markierte einen entscheidenden Wendepunkt in der Geschichte der Elektronische Rechner. Entwickelt während des Zweiten Weltkriegs, stellte dieser Computer einen revolutionären Durchbruch in der Rechentechnologie dar.

Die Entstehung des ENIAC war eng mit militärischen Forschungsbedürfnissen verbunden. Das Projekt wurde am University of Pennsylvania’s Moore School of Electrical Engineering initiiert, um komplexe ballistische Berechnungen für das US-Militär durchzuführen.

Das ENIAC-Projekt: Technische Grundlagen

Die Entwickler John Mauchly und J. Presper Eckert schufen einen Elektronische Rechner, der grundlegend anders war als bisherige mechanische Rechenmaschinen:

- Verwendung von 17.468 Elektronenröhren

- Gewicht von etwa 30 Tonnen

- Fläche von ungefähr 167 Quadratmetern

- Rechengeschwindigkeit von 5.000 Additionen pro Sekunde

Technische Innovationen des ENIAC

Der ENIAC war der erste vollelektronische Universalrechner, der komplexe mathematische Berechnungen in Sekundenschnelle durchführen konnte. Seine Technologie nutzte Elektronenröhren anstelle mechanischer Relais, was einen enormen Geschwindigkeitsvorteil bedeutete.

Die Bedeutung des ENIAC für die Computerentwicklung kann nicht überschätzt werden. Er legte den Grundstein für moderne Computersysteme und zeigte das enorme Potenzial elektronischer Rechenmaschinen.

Alan Turing und die Grundlagen der Informatik

Alan Turing gehört zu den bedeutendsten Pionieren der Informatik des 20. Jahrhunderts. Seine revolutionäre Arbeit legte die theoretischen Grundlagen für moderne Computersysteme und künstliche Intelligenz. Im Jahr 1937 veröffentlichte er einen wegweisenden Artikel über die Turingmaschine, ein abstraktes mathematisches Modell, das den Algorithmusbegriff grundlegend definierte.

Während des Zweiten Weltkriegs spielte Turing eine entscheidende Rolle bei der Entschlüsselung des Enigma-Codes. Seine kryptographischen Fähigkeiten halfen den Alliierten, geheime Nachrichten der deutschen Wehrmacht zu entschlüsseln und den Kriegsverlauf zu beeinflussen.

- Entwicklung des Turingmaschinen-Konzepts

- Grundlagen der Computerwissenschaft

- Beiträge zur künstlichen Intelligenz

- Entschlüsselung des Enigma-Codes

Turings Ideen waren seiner Zeit weit voraus. Er entwarf theoretische Modelle, die später die Entwicklung von Computern und Programmiersprachen maßgeblich beeinflussten. Seine Arbeiten gelten heute als Fundament der modernen Informatik und Computertechnologie.

„Maschinen werden eines Tages denken können, so wie Menschen es tun.“ – Alan Turing

Trotz seiner herausragenden wissenschaftlichen Leistungen erfuhr Turing zu Lebzeiten wenig Anerkennung. Aufgrund seiner Homosexualität wurde er gesellschaftlich diskriminiert, was tragischerweise zu seinem frühen Tod führte. Erst posthum wurde er als einer der wichtigsten Pioniere der Informatik gewürdigt.

Die Geburt des Personal Computers

Die Computerentwicklung nahm in den 1970er Jahren eine entscheidende Wendung. Frühe Computer waren zunächst große, teure Maschinen, die nur Unternehmen und Regierungen besitzen konnten. Mit dem Aufkommen der Mikrocomputertechnologie begann eine Revolution, die Computertechnologie für jedermann zugänglich machte.

Die Entwicklung des Personal Computers markierte einen Wendepunkt in der Technologiegeschichte. Zwei Unternehmen spielten dabei eine Schlüsselrolle:

Apple und die Heimcomputer-Revolution

Steve Jobs und Steve Wozniak gründeten Apple mit einer Vision: Computer für den Durchschnittshaushalt zu entwickeln. Ihre Meilensteine waren:

- 1976: Vorstellung des Apple I

- 1977: Einführung des Apple II

- Entwicklung benutzerfreundlicher Interfaces

- Demokratisierung der Computertechnologie

IBM PC – Ein Standard entsteht

1981 betrat IBM die Mikrocomputerszene und definierte neue Industriestandards. Der IBM PC setzte Maßstäbe für Kompatibilität und Leistung, die die gesamte Computerentwicklung beeinflussten.

„Computer sind wie ein Fahrrad für unseren Geist.“ – Steve Jobs

Diese Innovationen läuteten das digitale Zeitalter ein und machten Computertechnologie zu einem unverzichtbaren Teil unseres täglichen Lebens.

Wichtige Meilensteine der Computertechnologie

Die Computergeschichte ist geprägt von bahnbrechenden Innovationen, die unsere digitale Welt grundlegend verändert haben. Der erste Mikroprozessor von Intel im Jahr 1971 markierte einen entscheidenden Wendepunkt in der Computerentwicklung.

Wichtige technologische Durchbrüche haben die Computerentwicklung rasant vorangetrieben:

- 1971: Intel 4004 Mikroprozessor revolutioniert Rechentechnologie

- 1981: IBM PC macht Computer für Unternehmen zugänglich

- 1989: World Wide Web eröffnet globale Kommunikationsmöglichkeiten

- 2007: Smartphone-Revolution durch Apple iPhone

Die Miniaturisierung und Leistungssteigerung von Computern beschleunigten technologische Fortschritte enorm.

| Zeitraum | Technologische Innovation | Bedeutung |

|---|---|---|

| 1970er | Mikroprozessoren | Grundlage moderner Computer |

| 1990er | Internet | Globale Vernetzung |

| 2000er | Cloud Computing | Dezentrale Datenverarbeitung |

Aktuelle Trends wie künstliche Intelligenz und Quantencomputing versprechen weitere revolutionäre Entwicklungen in der Computergeschichte.

Die deutsche Computerindustrie im internationalen Vergleich

Die Computergeschichte Deutschlands ist eng mit bahnbrechenden Innovationen verbunden. Konrad Zuse spielte eine Schlüsselrolle in der Computerentwicklung, als er 1949 die Zuse KG gründete – eines der ersten Computerunternehmen weltweit.

Deutsche Unternehmen entwickelten sich zu bedeutenden Akteuren in der globalen Technologielandschaft. Siemens und andere Technologiefirmen etablierten Deutschland als wichtigen Innovationsstandort.

- Zuse KG als Pionierunternehmen der Computerentwicklung

- Starke Forschung und Entwicklung in Technologiezentren

- Internationale Wettbewerbsfähigkeit deutscher Technologieunternehmen

| Unternehmen | Gründungsjahr | Bedeutung |

|---|---|---|

| Zuse KG | 1949 | Erste deutsche Computerproduktion |

| Siemens | 1847 | Globaler Technologieführer |

| SAP | 1972 | Weltweite Softwarelösungen |

Die deutsche Computerindustrie bewies ihre Innovationskraft durch kontinuierliche technologische Fortschritte. Trotz internationaler Konkurrenz behauptete Deutschland seine Position als wichtiger Technologiestandort.

„Innovation unterscheidet zwischen einem Führenden und einem Nachahmer.“ – Steve Jobs

Aktuell investiert Deutschland massiv in Digitaltechnologien und künstliche Intelligenz, um wettbewerbsfähig zu bleiben und die Zukunft der Computertechnologie aktiv mitzugestalten.

Fazit

Die Computergeschichte ist eine faszinierende Reise durch menschliche Innovation. Die Erfindung des Computers war kein einzelnes Ereignis, sondern ein komplexer Prozess, an dem zahlreiche brillante Köpfe beteiligt waren. Von mechanischen Rechenmaschinen bis zu modernen digitalen Systemen entwickelte sich die Computertechnologie durch das Zusammenwirken verschiedener Pioniere.

Wegweisende Persönlichkeiten wie Konrad Zuse, Alan Turing und John von Neumann legten entscheidende Grundlagen für unsere heutige Computerwelt. Ihre Innovationen zeigten, dass technologischer Fortschritt ein kollektives Unterfangen ist, bei dem jeder Beitrag wichtig ist. Die Computergeschichte demonstriert eindrucksvoll, wie Kreativität und technisches Verständnis zusammenwirken.

Blicken wir in die Zukunft, wird deutlich, dass Computer unsere Gesellschaft weiterhin grundlegend prägen werden. Die Erfindung des Computers hat nicht nur die Technologie revolutioniert, sondern auch unsere Art zu denken, zu arbeiten und zu kommunizieren tiefgreifend verändert. Sie bleibt ein Symbol menschlicher Vorstellungskraft und technologischen Fortschritts.

Die Reise der Computertechnologie ist weit davon entfernt, abgeschlossen zu sein. Neue Entwicklungen in künstlicher Intelligenz, Quantencomputing und vernetzten Systemen versprechen aufregende Perspektiven für kommende Generationen.